CEO Nvidia Jensen Huang cho biết mẫu chip AI mới nhất Blackwell B200 của hãng sẽ có giá từ 30.000 đến 40.000 USD, tương tự GPU H100.

“Mức giá này dựa trên những phát minh và các công nghệ mới, biến thứ không thể thành hiện thực”, Jensen Huang nói với CNBC về chip Blackwell B200 sau lễ ra mắt ngày 19/3.

Người đứng đầu Nvidia cho biết họ đã chi 10 tỷ USD cho chi phí nghiên cứu và phát triển GPU mới. Giá bán trên “chỉ ở mức gần đúng”, bởi Nvidia hiện chuyển hướng bán giải pháp trọn gói cho trung tâm dữ liệu, tức còn phần mềm, đóng gói… “Chi phí không chỉ ở chip xử lý, mà còn ở việc thiết kế trung tâm dữ liệu và tích hợp vào trung tâm dữ liệu của công ty khác, điều Nvidia tiên phong”, ông nói.

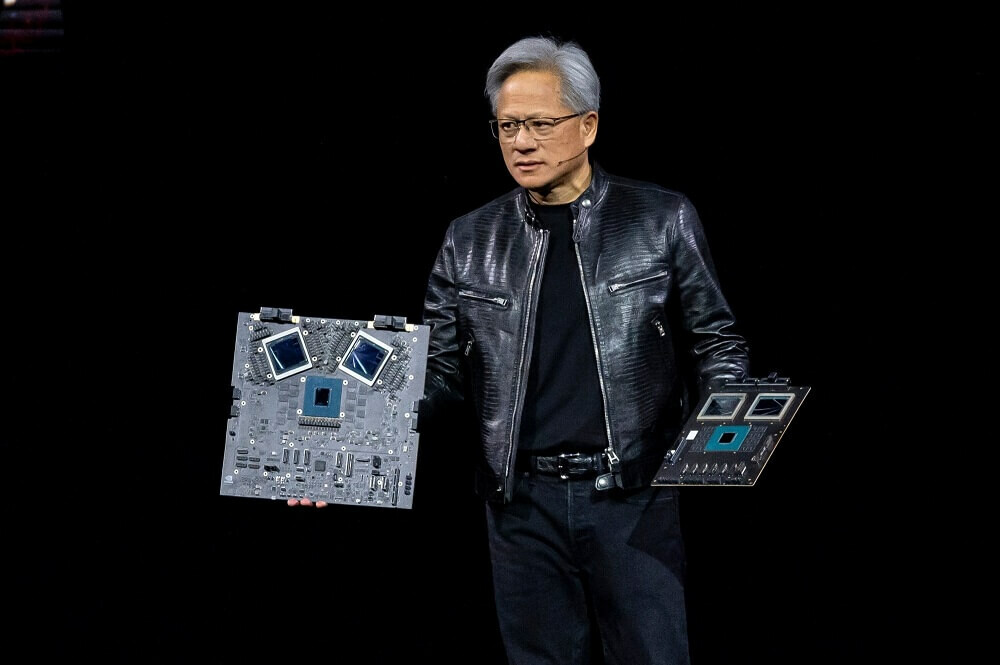

Tại sự kiện giới thiệu GPU Blackwell B200 ngày ở San Jose, California sáng 19/3 (giờ Hà Nội), Nvidia không đề cập giá sản phẩm. Thế hệ chip Blackwell hiện có nhiều lựa chọn, phục vụ từ trung tâm dữ liệu và hệ thống máy chủ AI lớn đến khách hàng cá nhân.

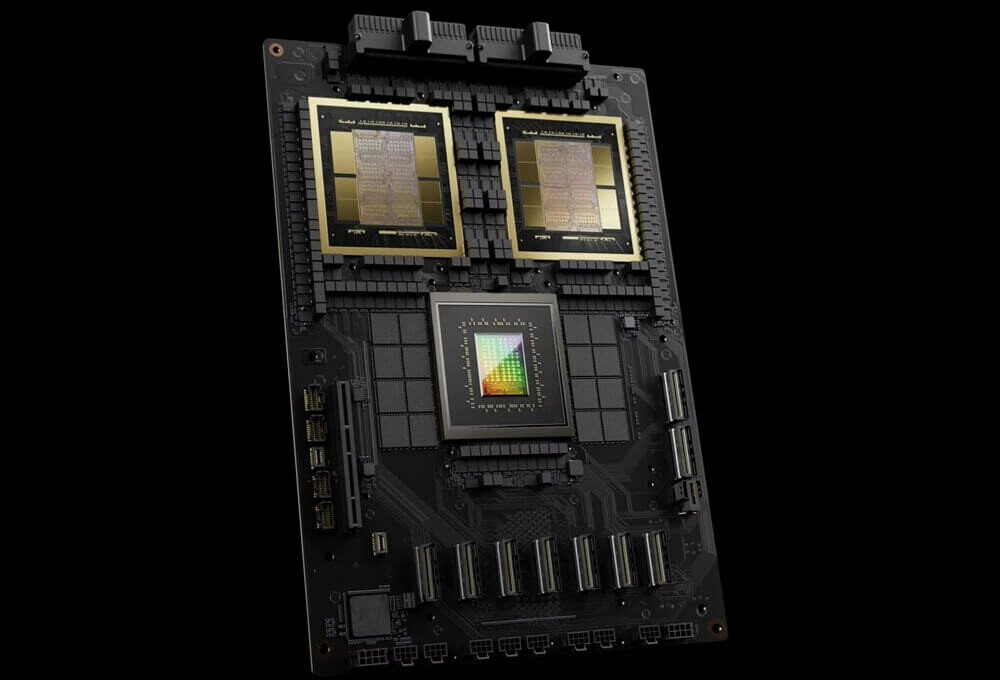

Năm ngoái, các đối tác của Nvidia từng bán mẫu H100 với giá 30.000-40.000 USD. Tuy nhiên, việc so sánh mức giá rất phức tạp, do Blackwell B200 sử dụng giải pháp khuôn kép với tổng số bóng bán dẫn lên tới 204 tỷ (104 tỷ mỗi khuôn), còn H100 là 80 tỷ bóng bán dẫn. Phiên bản khuôn kép của H100 là H100 NVL chưa được công khai giá.